隨著大規(guī)模語言模型(LLM)的蓬勃發(fā)展,訓(xùn)練千億乃至萬億參數(shù)級別的模型已成為AI領(lǐng)域的前沿陣地。模型規(guī)模的指數(shù)級增長對底層的數(shù)據(jù)處理與存儲支持服務(wù)提出了前所未有的挑戰(zhàn)。優(yōu)雅地訓(xùn)練大模型,不僅需要先進(jìn)的算法與算力,更依賴于一套高效、可靠、可擴(kuò)展的數(shù)據(jù)流水線與存儲架構(gòu)。本文將探討如何構(gòu)建這樣一個支持體系,以應(yīng)對LLM訓(xùn)練中的數(shù)據(jù)洪流。

一、 數(shù)據(jù)預(yù)處理:規(guī)模化與智能化的平衡

大模型訓(xùn)練始于海量、多模態(tài)、高質(zhì)量的原始數(shù)據(jù)。優(yōu)雅的數(shù)據(jù)處理首要在于預(yù)處理流程的工業(yè)級設(shè)計。

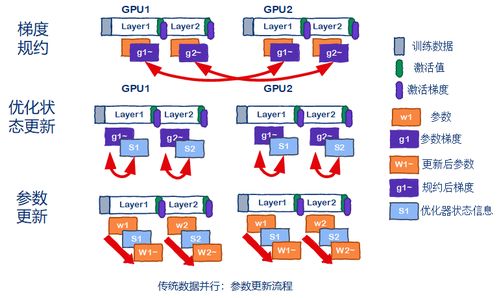

- 分布式數(shù)據(jù)攝取與清洗:利用如Apache Spark、Flink等分布式計算框架,構(gòu)建可橫向擴(kuò)展的數(shù)據(jù)攝取管道,并行處理TB/PB級原始文本、代碼、圖像等多源數(shù)據(jù)。清洗過程需自動化識別并過濾低質(zhì)量、重復(fù)、有害信息,同時結(jié)合小規(guī)模模型或規(guī)則引擎進(jìn)行智能去重與內(nèi)容安全過濾。

- 高效的Tokenizer與序列化:針對LLM,選擇或訓(xùn)練合適的Tokenizer(如BPE、SentencePiece),并將其集成到高效的C++/Rust后端中,實現(xiàn)分布式分詞與編碼。將文本數(shù)據(jù)預(yù)處理為可直接用于訓(xùn)練的序列化格式(如TFRecord、HDF5、Arrow),并建立索引,以支持后續(xù)的快速隨機(jī)訪問。

- 版本化與可復(fù)現(xiàn)性:所有原始數(shù)據(jù)、清洗后的數(shù)據(jù)、分詞詞典及處理代碼都應(yīng)進(jìn)行嚴(yán)格的版本控制(如DVC、Git LFS)。確保任何一次訓(xùn)練任務(wù)的數(shù)據(jù) lineage 清晰可溯,這是科學(xué)實驗與工程可復(fù)現(xiàn)性的基石。

二、 存儲架構(gòu):性能、成本與可靠性的三重奏

訓(xùn)練過程中,數(shù)據(jù)需要被高速、反復(fù)讀取。存儲系統(tǒng)的設(shè)計直接決定了訓(xùn)練效率的上限。

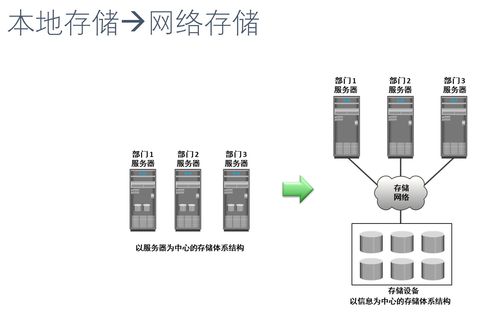

- 分層存儲策略:

- 熱存儲(高性能):使用全閃存陣列或高性能分布式文件系統(tǒng)(如Lustre、GPFS、WekaFS)存放當(dāng)前訓(xùn)練周期正在頻繁訪問的預(yù)處理后數(shù)據(jù)集。其超低延遲和高IOPS是保證GPU算力不被閑置的關(guān)鍵。

- 溫存儲(高吞吐):采用基于對象的存儲(如AWS S3、Google Cloud Storage、MinIO)或HDFS,作為中心化的數(shù)據(jù)湖,存放所有版本的處理后數(shù)據(jù)集、檢查點、日志等。它提供高吞吐的順序讀寫能力,適合數(shù)據(jù)加載和模型保存。

- 冷存儲(低成本):將不常訪問的原始數(shù)據(jù)、歷史檢查點歸檔至磁帶庫或冰川類存儲服務(wù),以極低成本滿足長期保存需求。

- 緩存與數(shù)據(jù)局部性優(yōu)化:在計算節(jié)點(GPU服務(wù)器)本地NVMe SSD上設(shè)置智能緩存層。訓(xùn)練開始前,將當(dāng)前任務(wù)所需的數(shù)據(jù)塊預(yù)加載至本地緩存;訓(xùn)練過程中,采用優(yōu)化的數(shù)據(jù)加載器(如PyTorch的DataLoader,結(jié)合WebDataset格式)實現(xiàn)流水線化,使數(shù)據(jù)準(zhǔn)備與GPU計算完全重疊,消除I/O瓶頸。

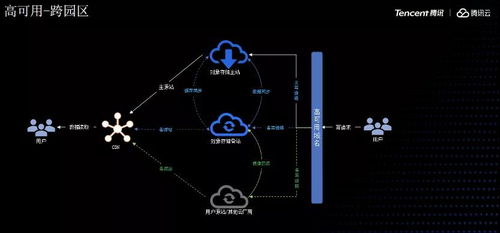

- 持久化與容錯:所有關(guān)鍵數(shù)據(jù)(原始數(shù)據(jù)、中間數(shù)據(jù)、模型檢查點)必須在分布式存儲中擁有多副本或糾刪碼保護(hù)。定期將訓(xùn)練檢查點同步至對象存儲,確保在發(fā)生硬件故障時能快速從最近狀態(tài)恢復(fù),避免數(shù)日計算成果毀于一旦。

三、 服務(wù)化與協(xié)同:提升研發(fā)效率

優(yōu)雅的體系最終要服務(wù)于研發(fā)團(tuán)隊,降低其數(shù)據(jù)管理負(fù)擔(dān)。

- 數(shù)據(jù)服務(wù)化:構(gòu)建內(nèi)部的數(shù)據(jù)平臺或服務(wù),提供統(tǒng)一的目錄查詢、數(shù)據(jù)預(yù)覽、樣本檢索、質(zhì)量報告和自助式數(shù)據(jù)訂閱功能。研究人員可以通過API或界面輕松獲取所需版本的數(shù)據(jù)集,而無需關(guān)心底層存儲位置與格式。

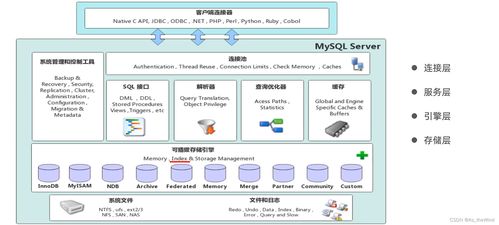

- 與訓(xùn)練框架深度集成:數(shù)據(jù)處理管道應(yīng)與PyTorch、TensorFlow、JAX等訓(xùn)練框架無縫對接。例如,利用NVIDIA的DALI庫進(jìn)行GPU加速的數(shù)據(jù)預(yù)處理,或使用Ray Data、TensorFlow tf.data API構(gòu)建端到端的分布式數(shù)據(jù)流水線,讓數(shù)據(jù)像水流一樣自然流入模型。

- 監(jiān)控與洞察:建立全面的監(jiān)控系統(tǒng),跟蹤數(shù)據(jù)流水線各階段的吞吐量、延遲、錯誤率以及存儲系統(tǒng)的容量、IO性能。利用這些指標(biāo)持續(xù)優(yōu)化數(shù)據(jù)流水線,并快速定位瓶頸。

四、 面向未來的考量

- 持續(xù)學(xué)習(xí)與數(shù)據(jù)迭代:LLM需要持續(xù)進(jìn)化。數(shù)據(jù)處理體系應(yīng)支持增量數(shù)據(jù)的無縫接入、與已有數(shù)據(jù)的融合去重,以及面向新任務(wù)的動態(tài)數(shù)據(jù)采樣與混合策略。

- 合規(guī)與隱私:在處理海量公開數(shù)據(jù)時,必須內(nèi)置數(shù)據(jù)版權(quán)過濾、個人信息脫敏機(jī)制,并建立數(shù)據(jù)使用審計跟蹤,以滿足日益嚴(yán)格的法規(guī)要求。

- 成本優(yōu)化:通過數(shù)據(jù)壓縮(如Zstandard)、智能生命周期管理(自動將冷數(shù)據(jù)遷移至廉價存儲)、按需供給等策略,在保證性能的控制龐大數(shù)據(jù)工程的總擁有成本。

在LLM盛行的今天,“優(yōu)雅地訓(xùn)練大模型”是一場系統(tǒng)工程的藝術(shù)。其核心在于認(rèn)識到數(shù)據(jù)是模型的“第一性原理”,并圍繞這一原理,構(gòu)建一個兼具自動化處理能力、高性能存儲訪問、強(qiáng)韌服務(wù)化支持的數(shù)據(jù)基礎(chǔ)設(shè)施。唯有如此,才能讓寶貴的算力資源完全聚焦于模型本身的創(chuàng)新與突破,從而在AI競賽中贏得先機(jī)。